UEFI, LVM и RAID 1 (GPT формат на дисковете)

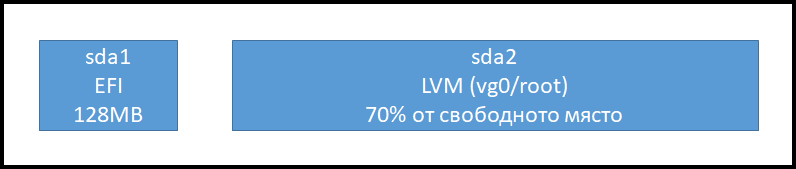

Имаме машина с два процесора, 4GB RAM и два твърди диска по 33GB. Ползваме UEFI вместо BIOS. В по-ранни статии обяснявах разликата между UEFI и BIOS. Тук няма да влизаме в подробности, а в сгъстен вид ще покажа случая. Ще инсталираме Debian 12 като зареждащия дял EFI ще е отделен, а всичко останало (/home, /, /var и т.н) ще са във виртуалния дял root на виртуланата групя vg0 на LVM. Схемата на разделение на диска ще е:

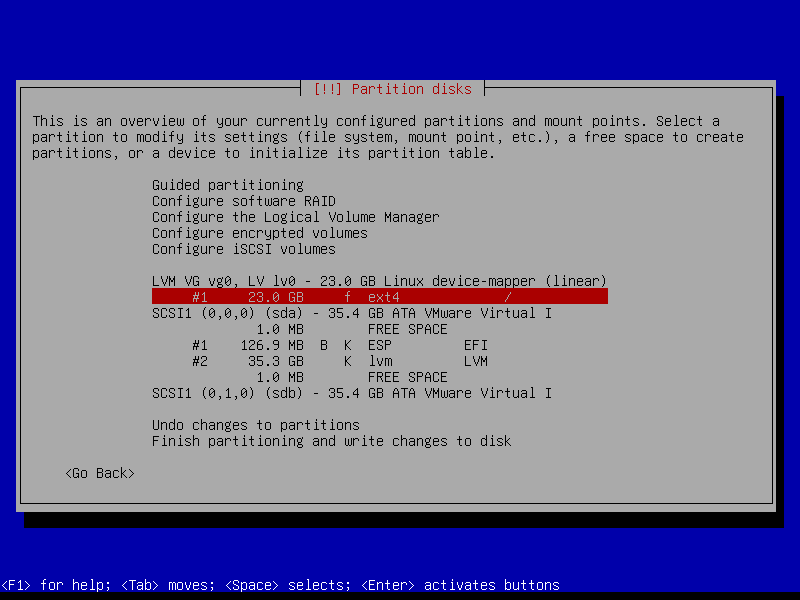

Имаме дял LVM. В него ще имаме логическа група vg0 и логически том root. По-надолу ще покажем точно какво става. Избираме първия диск за делене.

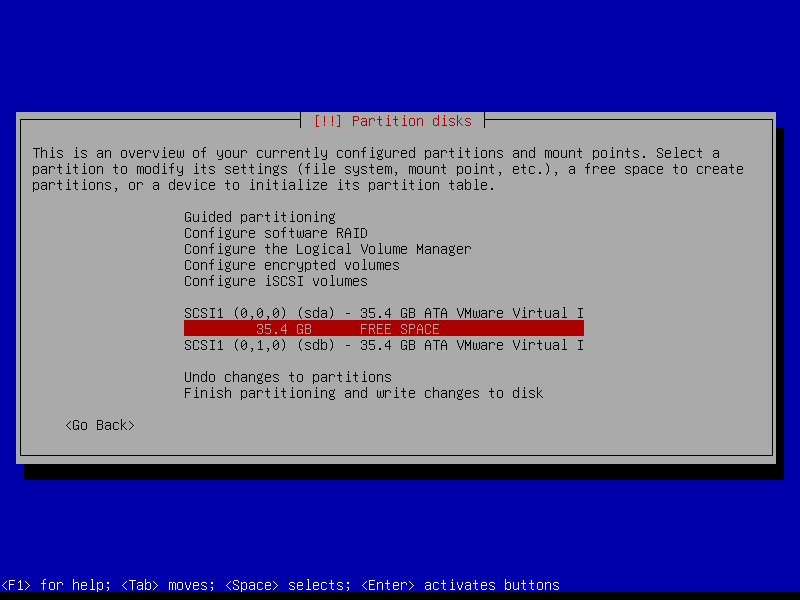

Диска е 33GB но тук се показва като 35.4GB. Да създадем EFI дял и LVM.

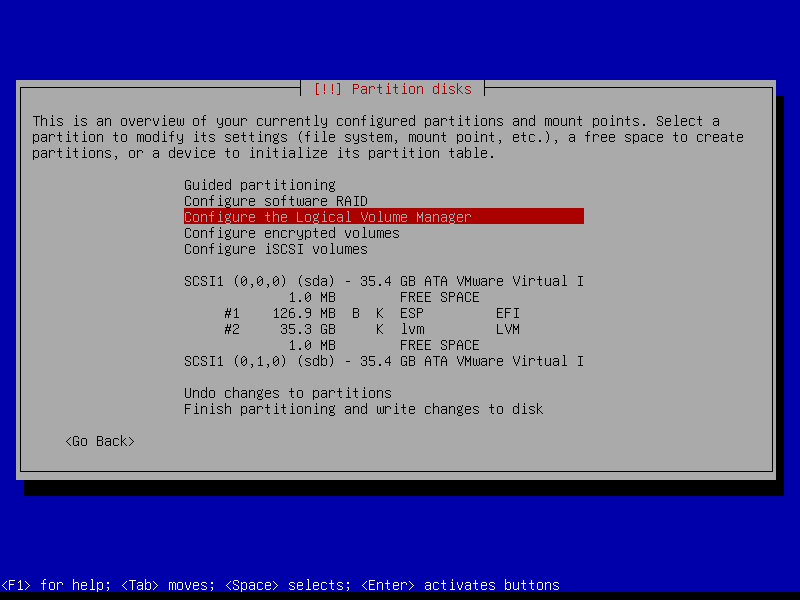

Имаме 2 дяла. Да конфигурираме LVM, който е втори и е с размер 35.3GB.

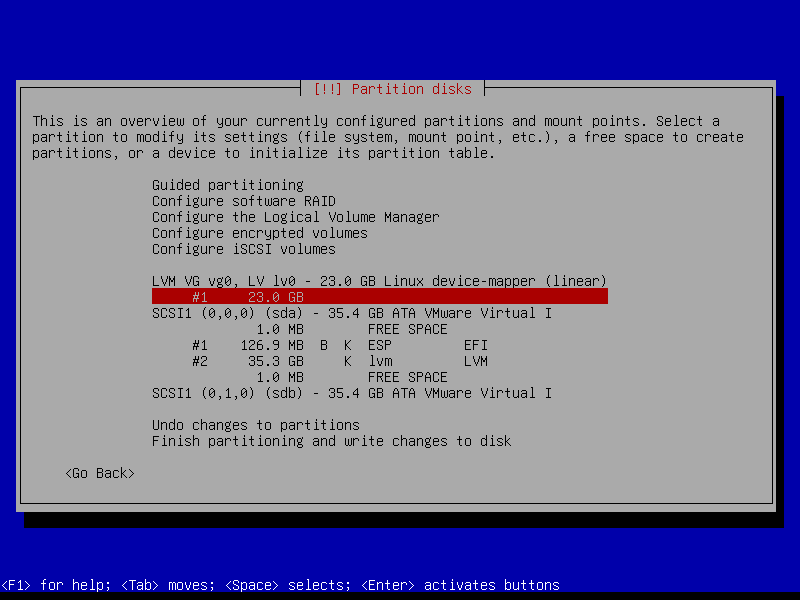

Конфигурирахме LVM. Създадохме логическа група vg0 и в нея логически дял lv0. lv0 не заема цялото свободно пространство от втория дял, а само 70%. В случая това е 23GB. Да укажем lv0 как да се монтира в операционната система.

Ще монтираме корена на системата /. На по-късен етап може да увеличим размера на логическия дял. Обърнете внимание, нямаме SWAP дял. Ще го създадем по-късно във вид на файл. До края инсталацията протича стандартно. След рестарта да проверим разпределението на диска.

lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS sda 8:0 0 33G 0 disk ├─sda1 8:1 0 121M 0 part /boot/efi └─sda2 8:2 0 32.9G 0 part └─vg0-lv0 254:0 0 21.4G 0 lvm / sdb 8:16 0 33G 0 disk sr0 11:0 1 632M 0 rom

Диска sda има два дяла. sda1 е EFI, а sda2 е LVM. Съответно в sda2 има създадена логическа група vg0 и в тази група има създаден логически том lv0. lv0 е с размер 21.4G. Ако погледнем ще видим, че sda2 е с размер 32.9G. Това означава, че имаме свободно място в което можем да разширяваме виртуалния дял lv0. Задачата ни обаче е да създадем RAID1 за устойчивост на системата. Отново няма да се впускам в подробности но идеята е да изградим софтуерен RAID1 за дяла EFI и RAID1 за LVM. Като изпълнението за LVM ще е върху възможностите на самия LVM. Може да звучи объркващо но по-надолу ще стане ясно. За начало да разделим втория диск да е огледален на първия. Проверяваме първия диск как е разделен:

fdisk /dev/sda Command (m for help): p Disk /dev/sdb: 33 GiB, 35433480192 bytes, 69206016 sectors Disk model: VMware Virtual I Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: gpt Disk identifier: 8D2C6B25-B18C-4544-9E77-A567E60E6828 Device Start End Sectors Size Type /dev/sda1 2048 249855 247808 121M EFI System /dev/sda2 249856 69203967 68954112 32.9G Linux LVM q

Да разделим и /dev/sdb както /dev/sda.

fdisk /dev/sdb ### За да видим всички команди: Command (m for help): m ### Разделяме диска, дефинираме го като GPT g Created a new GPT disklabel (GUID: 2B521237-82A9-6548-96D0-F7D2C18975B2). ### Създаваме нов дял Command (m for help): n Partition number (1-128, default 1): 1 First sector (2048-69205982, default 2048): 2048 Last sector, +/-sectors or +/-size{K,M,G,T,P} (2048-69205982, default 69203967): 249855 Created a new partition 1 of type 'Linux filesystem' and of size 121 MiB. ### Промяна на типа на дяла Command (m for help): t Selected partition 1 Partition type or alias (type L to list all): L Selected partition 1 Partition type or alias (type L to list all): L 1 EFI System C12A7328-F81F-11D2-BA4B-00A0C93EC93B 2 MBR partition scheme 024DEE41-33E7-11D3-9D69-0008C781F39F 3 Intel Fast Flash D3BFE2DE-3DAF-11DF-BA40-E3A556D89593 ......... ......... ......... q Partition type or alias (type L to list all): 1 Changed type of partition 'Linux filesystem' to 'EFI System'. Command (m for help): n Partition number (2-128, default 2): 2 First sector (249856-69205982, default 249856): натискаме ENTER Last sector, +/-sectors or +/-size{K,M,G,T,P} (249856-69205982, default 69203967): натискаме ENTER Created a new partition 2 of type 'Linux filesystem' and of size 32.9 GiB. Command (m for help): t Partition number (1,2, default 2): натискаме ENTER Partition type or alias (type L to list all): 43 Changed type of partition 'Linux root (MIPS-64 LE)' to 'Linux LVM'. Command (m for help): p Disk /dev/sdb: 33 GiB, 35433480192 bytes, 69206016 sectors Disk model: VMware Virtual I Units: sectors of 1 * 512 = 512 bytes Sector size (logical/physical): 512 bytes / 512 bytes I/O size (minimum/optimal): 512 bytes / 512 bytes Disklabel type: gpt Disk identifier: 41A78CDC-DADA-F943-B32A-926E3CCF4BC1 Device Start End Sectors Size Type /dev/sdb1 2048 249855 247808 121M EFI System /dev/sdb2 249856 69203967 68954112 32.9G Linux LVM ### Записваме промените и излизаме Command (m for help): w The partition table has been altered. Calling ioctl() to re-read partition table. Syncing disks.

Двата диска sda, sdb са еднакво разделени с еднакви дялове по логика.

Изграждане на LVM RAID1

Двата диска са еднакво разделени. Да се заемем с изграждането на RAID1 на LVM дяла. За целта първо да видим какво имаме до тук.

pvs PV VG Fmt Attr PSize PFree /dev/sda2 vg0 lvm2 a-- <32.88g 11.46g vgs VG #PV #LV #SN Attr VSize VFree vg0 1 1 0 wz--n- <32.88g 11.46g lvs LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert lv0 vg0 -wi-ao---- <21.42g

Имаме един диск в pv, една логическа група със един диск и един логически дял в логическата група. По-подробна информация може да видим чрез:

pvdisplay --- Physical volume --- PV Name /dev/sda2 VG Name vg0 PV Size <32.88 GiB / not usable 0 Allocatable yes PE Size 4.00 MiB Total PE 8417 Free PE 2934 Allocated PE 5483 PV UUID SuPiah-miva-KcYU-x2gf-EKoV-kHAB-rjx2eZ vgdisplay --- Volume group --- VG Name vg0 System ID Format lvm2 Metadata Areas 1 Metadata Sequence No 2 VG Access read/write VG Status resizable MAX LV 0 Cur LV 1 Open LV 1 Max PV 0 Cur PV 1 Act PV 1 VG Size <32.88 GiB PE Size 4.00 MiB Total PE 8417 Alloc PE / Size 5483 / <21.42 GiB Free PE / Size 2934 / 11.46 GiB VG UUID soxeMc-czOT-Gxqy-heQU-tXlQ-B5GE-tqeLQA lvdisplay --- Logical volume --- LV Path /dev/vg0/lv0 LV Name lv0 VG Name vg0 LV UUID IqpS24-etWh-QuK6-vj8Z-bVQi-8M3e-Hx8uHQ LV Write Access read/write LV Creation host, time debian, 2025-04-19 14:34:11 -0400 LV Status available # open 1 LV Size <21.42 GiB Current LE 5483 Segments 1 Allocation inherit Read ahead sectors auto - currently set to 256 Block device 254:0

Виждаме, че във PV имаме един диск. За RAIDA ни е необходим още един. Да добавим такъв.

pvcreate /dev/sdb2 Physical volume "/dev/sdb2" successfully created. pvs PV VG Fmt Attr PSize PFree /dev/sda2 vg0 lvm2 a-- &lg32.88g 11.46g /dev/sdb2 lvm2 --- <32.88g <32.88g

Вече имаме 2 диска. Да разширим логическата група vg0 с /dev/sda2.

vgextend vg0 /dev/sdb2 Volume group "vg0" successfully extended vgs VG #PV #LV #SN Attr VSize VFree vg0 2 1 0 wz--n- <65.76g <44.34g

Забележете, размера на групата се увеличи двойно (65.76GB). В групата имаме 2 диска (PV = 2). Следва дефиниране на самия RAID1. Ще го създадем чрез логическия дял lv0.

lvconvert --type raid1 -m 1 vg0/lv0 Are you sure you want to convert linear LV vg0/lv0 to raid1 with 2 images enhancing resilience? [y/n]: y Logical volume vg0/lv0 successfully converted. lvs LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert lv0 vg0 rwi-aor--- <21.42g 19.92

Двата диска са синхронизирани на 19.92%. Изчакваме до 100% синхронизация.

lvs LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert lv0 vg0 rwi-aor--- <21.42g 100.00

Готово! Двата диска са синхронизирани. Да проверим:

lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS sda 8:0 0 33G 0 disk ├─sda1 8:1 0 121M 0 part /boot/efi └─sda2 8:2 0 32.9G 0 part ├─vg0-lv0_rmeta_0 254:1 0 4M 0 lvm │ └─vg0-lv0 254:0 0 21.4G 0 lvm / └─vg0-lv0_rimage_0 254:2 0 21.4G 0 lvm └─vg0-lv0 254:0 0 21.4G 0 lvm / sdb 8:16 0 33G 0 disk ├─sdb1 8:17 0 121M 0 part └─sdb2 8:18 0 32.9G 0 part ├─vg0-lv0_rmeta_1 254:3 0 4M 0 lvm │ └─vg0-lv0 254:0 0 21.4G 0 lvm / └─vg0-lv0_rimage_1 254:4 0 21.4G 0 lvm └─vg0-lv0 254:0 0 21.4G 0 lvm / sr0 11:0 1 632M 0 rom

sda1 и sdb1 не са еднакви. Това ще е следващата задача.

pvdisplay --- Physical volume --- PV Name /dev/sda2 VG Name vg0 PV Size <32.88 GiB / not usable 0 Allocatable yes PE Size 4.00 MiB Total PE 8417 Free PE 2933 Allocated PE 5484 PV UUID SuPiah-miva-KcYU-x2gf-EKoV-kHAB-rjx2eZ --- Physical volume --- PV Name /dev/sdb2 VG Name vg0 PV Size <32.88 GiB / not usable 0 Allocatable yes PE Size 4.00 MiB Total PE 8417 Free PE 2933 Allocated PE 5484 PV UUID CmCQny-0iHz-z2uV-z6k8-sCVF-f7y5-0j4J6j vgdisplay --- Volume group --- VG Name vg0 System ID Format lvm2 Metadata Areas 2 Metadata Sequence No 6 VG Access read/write VG Status resizable MAX LV 0 Cur LV 1 Open LV 1 Max PV 0 Cur PV 2 Act PV 2 VG Size <65.76 GiB PE Size 4.00 MiB Total PE 16834 Alloc PE / Size 10968 / 42.84 GiB Free PE / Size 5866 / 22.91 GiB VG UUID soxeMc-czOT-Gxqy-heQU-tXlQ-B5GE-tqeLQA lvdisplay --- Logical volume --- LV Path /dev/vg0/lv0 LV Name lv0 VG Name vg0 LV UUID IqpS24-etWh-QuK6-vj8Z-bVQi-8M3e-Hx8uHQ LV Write Access read/write LV Creation host, time debian, 2025-04-19 14:34:11 -0400 LV Status available # open 1 LV Size <21.42 GiB Current LE 5483 Mirrored volumes 2 Segments 1 Allocation inherit Read ahead sectors auto - currently set to 256 Block device 254:0

RAID-a е изграден върху LVM структура.

Дефиниране на EFI (зареждащия дял)

За да работи правилно системата EFI дяла трябва да е извън LVM-a. За работи системата безотказно ще изградим софтуерен RAID1 масив от двата EFI дяла (/dev/sda1, /dev/sdb1). В по-предни статии показвах как зарежда системата при UEFI, даже показвах как се изгражда RAID1 масива. Независимо от това ще повторим упражнението. Не знам дали забелязахте но след рестарт на системата отново се промениха дяловете. Отново първоначалната инсталация застана на /dev/sda. За да няма това бъркане правилния начин е работата с UUID. Да проверим как зарежда системата:

efibootmgr -v | grep -i debian Boot0005* debian HD(1,GPT,9451b8e7-bf99-42e3-89ee-7ec9508ad6b5,0x800,0x3c800)/File(\EFI\debian\shimx64.efi) lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS sda 8:0 0 33G 0 disk ├─sda1 8:1 0 121M 0 part /boot/efi └─sda2 8:2 0 32.9G 0 part ├─vg0-lv0_rmeta_0 254:1 0 4M 0 lvm │ └─vg0-lv0 254:0 0 21.4G 0 lvm / └─vg0-lv0_rimage_0 254:2 0 21.4G 0 lvm └─vg0-lv0 254:0 0 21.4G 0 lvm / sdb 8:16 0 33G 0 disk ├─sdb1 8:17 0 121M 0 part └─sdb2 8:18 0 32.9G 0 part ├─vg0-lv0_rmeta_1 254:3 0 4M 0 lvm │ └─vg0-lv0 254:0 0 21.4G 0 lvm / └─vg0-lv0_rimage_1 254:4 0 21.4G 0 lvm └─vg0-lv0 254:0 0 21.4G 0 lvm / sr0 11:0 1 632M 0 rom ls -l /dev/disk/by-partuuid/ total 0 lrwxrwxrwx 1 root root 10 Apr 19 16:33 9451b8e7-bf99-42e3-89ee-7ec9508ad6b5 -> ../../ sda1 lrwxrwxrwx 1 root root 10 Apr 19 16:35 b8134161-68eb-5647-98f8-2354d697eda0 -> ../../sdb2 lrwxrwxrwx 1 root root 10 Apr 19 16:35 dd0976db-5c4f-48a3-a512-7cf5289220e4 -> ../../sda2 lrwxrwxrwx 1 root root 10 Apr 19 16:33 fa5e459a-68fb-b942-92a1-dc2f12c751d3 -> ../../sdb1

Да клонираме /dev/sdb1 да е като /dev/sda1. Проверяваме как е монтиран /boot/efi и след това клонираме дяла.

mount | grep '/boot/efi' /dev/sda1 on /boot/efi type vfat (rw,relatime,fmask=0077,dmask=0077,codepage=437,iocharset=ascii,shortname=mixed,utf8,errors=remount-ro) dd if=/dev/sda1 of=/dev/sdb1 247808+0 records in 247808+0 records out 126877696 bytes (127 MB, 121 MiB) copied, 8.90004 s, 14.3 MB/s

Отново да проверим как зарежда системата, използвайки efibootmgr.

efibootmgr -v | grep debian Boot0005* debian HD(1,GPT,9451b8e7-bf99-42e3-89ee-7ec9508ad6b5,0x800,0x3c800)/File(\EFI\debian\shimx64.efi)

Зареждаме само от един дял. Да добавим и втория.

efibootmgr --create --disk /dev/sdb --part 1 --label "debian2" --loader "\EFI\debian\shimx64.efi" BootCurrent: 0005 BootOrder: 0006,0005,0000,0001,0002,0003,0004 Boot0000* EFI VMware Virtual IDE Hard Drive (IDE 0:0) Boot0001* EFI VMware Virtual IDE Hard Drive (IDE 0:1) Boot0002* EFI VMware Virtual IDE CDROM Drive (IDE 1:0) Boot0003* EFI Network Boot0004* EFI Internal Shell (Unsupported option) Boot0005* debian Boot0006* debian2

Да проверим.

efibootmgr -v | grep -i debian Boot0005* debian HD(1,GPT,9451b8e7-bf99-42e3-89ee-7ec9508ad6b5,0x800,0x3c800)/File(\EFI\debian\shimx64.efi) Boot0006* debian2 HD(1,GPT,fa5e459a-68fb-b942-92a1-dc2f12c751d3,0x800,0x3c800)/File(\EFI\debian\shimx64.efi)

Зареждаме от двата диска. Ако се счупи единия диск да не спре работата след рестарт, а да може да зареди от другия. Повторно оглеждане.

ls -l /dev/disk/by-partuuid/ total 0 lrwxrwxrwx 1 root root 10 Apr 19 16:33 9451b8e7-bf99-42e3-89ee-7ec9508ad6b5 -> ../../sda1 lrwxrwxrwx 1 root root 10 Apr 19 16:35 b8134161-68eb-5647-98f8-2354d697eda0 -> ../../sdb2 lrwxrwxrwx 1 root root 10 Apr 19 16:35 dd0976db-5c4f-48a3-a512-7cf5289220e4 -> ../../sda2 lrwxrwxrwx 1 root root 10 Apr 19 17:08 fa5e459a-68fb-b942-92a1-dc2f12c751d3 -> ../../sdb1

Сравняваме ги с идентификаторите на зареждане.

efibootmgr -v BootCurrent: 0005 BootOrder: 0006,0005,0000,0001,0002,0003,0004 Boot0000* EFI VMware Virtual IDE Hard Drive (IDE 0:0) PciRoot(0x0)/Pci(0x7,0x1)/Ata(0,0,0) Boot0001* EFI VMware Virtual IDE Hard Drive (IDE 0:1) PciRoot(0x0)/Pci(0x7,0x1)/Ata(0,1,0) Boot0002* EFI VMware Virtual IDE CDROM Drive (IDE 1:0) PciRoot(0x0)/Pci(0x7,0x1)/Ata(1,0,0) Boot0003* EFI Network PciRoot(0x0)/Pci(0x11,0x0)/Pci(0x0,0x0)/MAC(000c29521985,0) Boot0004* EFI Internal Shell (Unsupported option) MemoryMapped(11,0xeb4d018,0xf07e017)/FvFile(c57ad6b7-0515-40a8-9d21-551652854e37) Boot0005* debian HD(1,GPT,9451b8e7-bf99-42e3-89ee-7ec9508ad6b5,0x800,0x3c800)/File(\EFI\debian\shimx64.efi) Boot0006* debian2 HD(1,GPT,fa5e459a-68fb-b942-92a1-dc2f12c751d3,0x800,0x3c800)/File(\EFI\debian\shimx64.efi)

Всичко е точно. Сега даже и да се счупи някой диск ще може да заредим от другия след рестарт на системата. Обаче за да се случи всичко това, също е необходимо двата дяла (sda1 и sdb1) да са в RAID1 и в /etc/fstab системата да стартира от RAID-a, а не от някой от двата дяла.

Обединяване на sda1 и sdb1 в RAID1 за EFI

Ще създадем RAID1 за /boot/efi. Тук има една тънкост. sda1 не трябва да е в RAID1 масива (за сега /boot/efi е все още само той), защото са необходими метаданни 1.0 за да се стартира EFI. Ще ползваме mdadm, който трябва също да се инсталира.

apt install mdadm -y mdadm --create /dev/md100 --level 1 --raid-disks 2 --metadata 1.0 /dev/sdb1 missing mdadm: partition table exists on /dev/sdb1 Continue creating array? yes mdadm: array /dev/md100 started.

Създаваме RAID1 от 2 диска. /dev/sda1 за сега няма да го вкарваме в масива, защото съдържанието му ще трябва да го прехвърлим в самия RAID1. Масива md100 се състои от /dev/sdb1 и missing (липсващ втори дял). Да копираме съдържанието на /dev/sda1 в RAID1 масива md100. За да се случи всичко това първо трябва да монтираме md100 примерно в /tmp/RAID. След това чрез програмата rsync ще прехвърлим данните от /boot/efi (разбирайте /dev/sda1) в /tmp/RAID.

mkdir /tmp/RAID mount /dev/md100 /tmp/RAID apt update -y apt install rsync -y rsync -av --progress /boot/efi/ /tmp/RAID/ sending incremental file list ./ EFI/ EFI/debian/ sent 223 bytes received 45 bytes 536.00 bytes/sec total size is 6,097,813 speedup is 22,753.03

Вече имаме всичко в RAID1 масива за зареждане от него. Обаче RAID1 масива е непълен. Да проверим това:

cat /proc/mdstat Personalities : [raid6] [raid5] [raid4] [raid1] md100 : active raid1 sdb1[0] 123840 blocks super 1.0 [2/1] [U_] unused devices: <none>

От дефинирани 2 дяла имаме налични само 1. Да добавим вече /dev/sda1. Първо ще го размонтираме от текущия път и ще го добавим в RAID1 масива.

umount /dev/sda1 mdadm --manage /dev/md100 --add /dev/sda1 mdadm: added /dev/sda1 cat /proc/mdstat Personalities : [raid6] [raid5] [raid4] [raid1] md100 : active raid1 sda1[2] sdb1[0] 123840 blocks super 1.0 [2/2] [UU] unused devices: <none>

Дефинирани 2 диска в RAID масива и двата са активни. Да добавим конфигурацията /dev/md100 към файла mdadm.conf.

mdadm --detail --scan | grep 100 >> /etc/mdadm/mdadm.conf cat /etc/mdadm/mdadm.conf ### много писано и следва ... # definitions of existing MD arrays # This configuration was auto-generated on Sat, 19 Apr 2025 21:25:58 -0400 by mkconf ARRAY /dev/md100 metadata=1.0 name=debian:100 UUID=d143584d:ca99ad16:38d61060:aa7eaf3f

Да добавим RAID масива в /etc/fstab.

nano /etc/fstab

#

Обновяваме INITRAMFS.

update-initramfs -u update-initramfs: Generating /boot/initrd.img-6.1.0-33-amd64

Рестартираме системата и проверяваме.

lsblk NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINTS sda 8:0 0 33G 0 disk ├─sda1 8:1 0 121M 0 part │ └─md100 9:100 0 120.9M 0 raid1 /boot/efi └─sda2 8:2 0 32.9G 0 part ├─vg0-lv0_rmeta_0 253:0 0 4M 0 lvm │ └─vg0-lv0 253:4 0 21.4G 0 lvm / └─vg0-lv0_rimage_0 253:1 0 21.4G 0 lvm └─vg0-lv0 253:4 0 21.4G 0 lvm / sdb 8:16 0 33G 0 disk ├─sdb1 8:17 0 121M 0 part │ └─md100 9:100 0 120.9M 0 raid1 /boot/efi └─sdb2 8:18 0 32.9G 0 part ├─vg0-lv0_rmeta_1 253:2 0 4M 0 lvm │ └─vg0-lv0 253:4 0 21.4G 0 lvm / └─vg0-lv0_rimage_1 253:3 0 21.4G 0 lvm └─vg0-lv0 253:4 0 21.4G 0 lvm / sr0 11:0 1 632M 0 rom pvs PV VG Fmt Attr PSize PFree /dev/sda2 vg0 lvm2 a-- <32.88g <11.46g /dev/sdb2 vg0 lvm2 a-- <32.88g <11.46g vgs VG #PV #LV #SN Attr VSize VFree vg0 2 1 0 wz--n- <65.76g 22.91g lvs LV VG Attr LSize Pool Origin Data% Meta% Move Log Cpy%Sync Convert lv0 vg0 rwi-aor--- <21.42g 100.00 lvdisplay --- Logical volume --- LV Path /dev/vg0/lv0 LV Name lv0 VG Name vg0 LV UUID IqpS24-etWh-QuK6-vj8Z-bVQi-8M3e-Hx8uHQ LV Write Access read/write LV Creation host, time debian, 2025-04-19 14:34:11 -0400 LV Status available # open 1 LV Size <21.42 GiB Current LE 5483 Mirrored volumes 2 Segments 1 Allocation inherit Read ahead sectors auto - currently set to 256 Block device 253:4 cat /proc/mdstat Personalities : [raid1] [raid6] [raid5] [raid4] [linear] [multipath] [raid0] [raid10] md100 : active raid1 sda1[2] sdb1[0] 123840 blocks super 1.0 [2/2] [UU]